Přejít k obsahu | Přejít k hlavnímu menu | Přejít k vyhledávání

Víte, proč jsou oblíbené bramborové lupínky Pringles ohnuté? Malá nápověda: nejde jen o design. Takzvané superpočítače zjistily, že aerodynamický tvar lupínků umožňuje rychlejší průjezd pecí a tak se ve stejném čase vyrobí více balení. Že více balení znamená více prodeje a více zisků, je potom už jen logickým vyústěním celé

Víte, proč jsou oblíbené bramborové lupínky Pringles ohnuté? Malá nápověda: nejde jen o design. Takzvané superpočítače zjistily, že aerodynamický tvar lupínků umožňuje rychlejší průjezd pecí a tak se ve stejném čase vyrobí více balení. Že více balení znamená více prodeje a více zisků, je potom už jen logickým vyústěním celé rovnice.

Ale tahle minianekdota s Pringles je samozřejmě spíš jen zábavnou vstupenkou do článku o „superpočítačích“ – o High Performance Computingu (HPC), který dnes ve světě už běžně využívají vlastně všichni leadeři ve svých oborech. Automobilky, konstruktéři letadel, meteorologové, genetici, farmaceuti – vlastně všichni. O dalším vývoji jsme se bavili s jedním z nejpovolanějších, Lubošem Kolářem, z české pobočky Hewlett Packard Enterprise. Firmy, která v globálním měřítku investuje stamilióny dolarů do vývoje nejdokonalejších superpočítačů a HPC technologií. Ano, a dodává také „nafukovací PC“.

Ano, lidé to milují. Je to líbivé na čtení. Vznikají přelomové vědecké objevy, hranice se posouvají vpřed. Málokoho už zaujme rutina, která je spojena se „standardním“ IT. Jako například jestli fabrika funguje, dokáže vyrobit díly, sestavit finální výrobek a dokáže dopředu spočítat, jestli na tom vydělá nebo prodělá. To už čtenáře tolik nezajímá, protože silnější je příběh, že jsme vzali standardní server, trošku jsme ho opancéřovali a poslali jsme ho do kosmu a on létá na vesmírné stanici ISS. Shodou náhod se ta řada serverů již dlouho jmenuje Apollo. Nicméně, zpátky k otázce. Superpočítače jsou realitou a firmy by bez nich vlastně nedokázaly být konkurenceschopné. Jsou všude. V korporacích, ve vědě, ve školství. A řeší se s jejich pomocí první poslední.

V České republice je několik superpočítačů ovšem za zmínku stojí především nejnovější superpočítač Salomon v Ostravě (Vysoká škola báňská), který je, od spuštění v roce 2015, v první stovce světového žebříčku nejvýkonnějších superpočítačů. I my jsme tak v určitém „VIP klubu“ a máme k dispozici rozumné nástroje, aby česká věda mohla využívat moderní technologie a potřebný objem výpočetního času. I my můžeme vyvíjet například takzvaná digitální dvojčata.

Ono se tomu tak říká. Nové výrobky dnes už vznikají jinak než dříve. V minulosti musel vždy vzniknout nejprve fyzický prototyp. Což bylo časově i finančně náročné. Jenže svět se výrazně zrychlil a kdo investuje do vývoje, chce být na trhu jako první. Proto, když se přijde na něco nového, zajímavého, tak to všichni chtějí na trh dát co nejrychleji. Tak už se nevyrábí fyzické prototypy – nebo jen v minimálním množství, které vyžaduje například legislativa. Ale dělají se prototypy digitální.

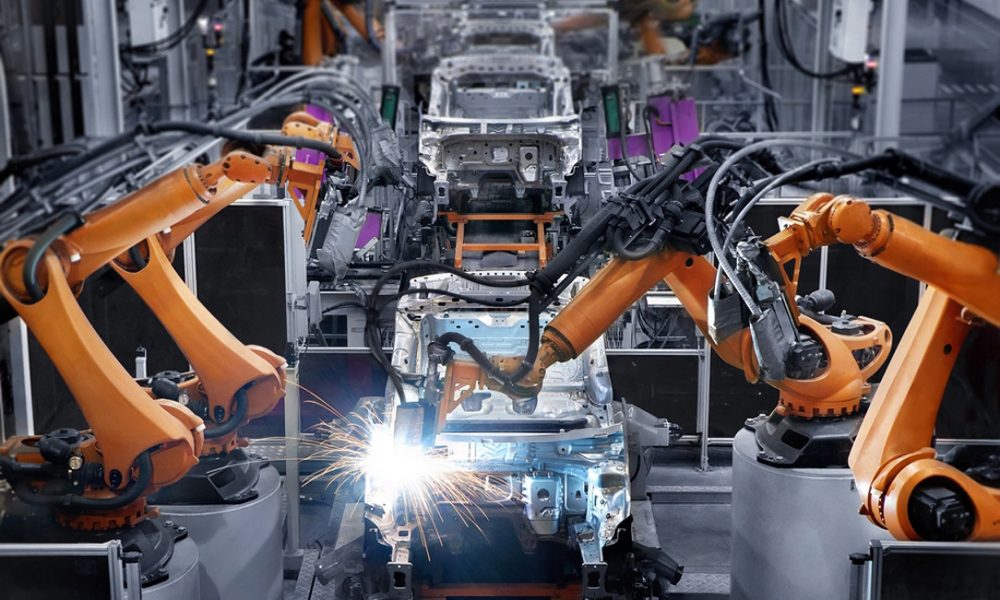

Připravuji nějaký nový výrobek a mám jeho 3D model v počítači. Ale potřebuji zjistit dopředu (aniž by byl vyroben byť jediný kus = prototyp) jeho fyzikální a užitné vlastnosti. Použiji tedy digitální interpretaci výrobku (digitální prototyp) a na řadu přichází HPC. Dělají se analýzy všeho druhu – např. proudění/aerodynamiky a vlivu automobilů na životní prostředí, crash analýzy a mnoho dalších věcí. To všechno se dá vypočítat. Jaká je pravděpodobnost, že se posádce nic nestane, když auto narazí do překážky. Nebo když se auto střetne s chodcem, tak aby byl chodec, díky chytré konstrukci automobilu, co nejvíce chráněn. Tohle všechno se dnes dělá na superpočítačích. A tak i česká ŠKODA AUTO má od nás poměrně velkou instalovanou bázi pro podporu výše uvedeného a dalších inženýrských analýz.

Velmi, navíc obvykle existují naměřená reálná data z praxe, s kterými je potřeba a digitální analýzy s jejich pomocí trvale optimalizovat a zpřesňovat. Lidstvo má obecně strašnou spoustu dat, kterou však neumí správně využít, spárovat a najít v té záplavě dat užitečné informace. Ale s použitím HPC, a nově též s nástupem metod „umělé inteligence“, to půjde čím dál lépe, přesněji, rychleji a hlavně automatizovaně.

„Velká data“ produkují také tradiční vědní obory zabývající se základním výzkumem, jako například kosmologie, výzkum mikro a nano částic. CERN – největší experiment, který kdy lidstvo postavilo, generuje obrovské množství dat a ta je třeba zpracovat a najít tam nějakou vhodnou oblast k dalšímu podrobnému zkoumání, kde může dojít k převratnému objevu. V Austrálii a Jižní Africe se budují tzv. „square kilometre array“, pole plná radioteleskopů sledujících vesmír a chrlících obrovské množství dat. A opět je třeba jejich výstupy efektivně analyzovat v reálném čase a zjistit, jestli se mezi tím obrovským množstvím šumu nalézá něco „zajímavého“. Pak tu jsou oblasti jako výpočetní chemie a fyzika zabývající se výzkumem nových materiálů a léků, dále pak genetika a genomika. Ale to je téma samo o sobě.

To už se pomalu dostáváme do oblastí využívajících tzv. „memory centric“ systémy – v úvodu zmíněná „nafukovací PC“. Je třeba analyzovat obrovská data z DNA sekvenátorů a prohledávat rozsáhlé referenční genomické databáze. Výsledek může sloužit v oborech jako je například personalizovaná medicína. Představte si situaci, že máte k dispozici svůj kompletní genetický obraz, zároveň onemocníte například rakovinou, udělají sken postižené tkáně a na základě této sady informací už z existujících léků namíchají „koktejl“ přesně pro vaši nemoc, přesně odpovídající vašim genetickým předpokladům tak, aby pravděpodobnost vyléčení byla co nejvyšší a zároveň léčba měla co nejmenší vedlejší účinky. A na to je potřeba superpočítač, který vše zpracuje.

Existují dva přístupy. Jednomu typu superpočítače se říká cluster. A to je v podstatě velká hromada standardních komoditních prvků (serverů a propojovacích sítí) pracujících dohromady na jedné úloze. Přidanou hodnotou naší firmy je, že to celé dokážeme společně ideálně naladit, zorchestrovat a dodat vyladěnou softwarovou vrstvu, která dokáže vytěžit maximum z té komoditní hardwarové platformy pro aplikační software. A samozřejmě uživatelům všestranně pomáhat při provozování.

A ten druhý přístup je memory centric, kde se v tuto chvílí jedná o velice specializovaný typ systémů, a to si lze představit laicky jako nafukovací PC. Čili máte tady notebook, v něm jeden procesor a 16 GB paměti. Tak si představte, že se vám nafoukne, bude mít v sobě stovky či tisíce procesorů a terabyty paměti, kterou všechny procesory celou vidí. Takový systém je pak velice výkonný, flexibilní a zároveň snadný na správu. A samozřejmě my se zabýváme technologiemi na pozadí, které to umožňují. Teď se hodně mluví o exascale. Exa je předpona, která značí výpočetní výkon 10 na osmnáctou operací za vteřinu.

Ne, byť se to zdá jako sci-fi. V současné době jsme v éře peta (1015), ten náš největší český superpočítač v Ostravě má výkon dva peta-FLOPSy. Exa je potom tím pádem 500x větší. A kdybyste si na standardní komoditní procesorové platformě měli představit, jak vypadá exa, tak to v současné době bude něco jako 350-400 tisíc serverů pracujících dohromady jako jeden superpočítač. A ten by měl výkon jeden exa-FLOPS. Očekává se, že takový systém bude ve světě postaven někdy v roce 2021. Tuto hranici chceme dosáhnout, ale to se musí ještě dokončit vývoj několika důležitých technologií, které to umožní.